随着数据驱动决策的普及,大数据治理已成为企业高效运营的核心支柱。数据处理作为大数据治理的关键环节,直接决定了数据质量、价值挖掘与合规性。本文围绕大数据治理解决方案中的数据处理,探讨其核心策略、技术工具及最佳实践。

一、数据处理在大数据治理中的重要性

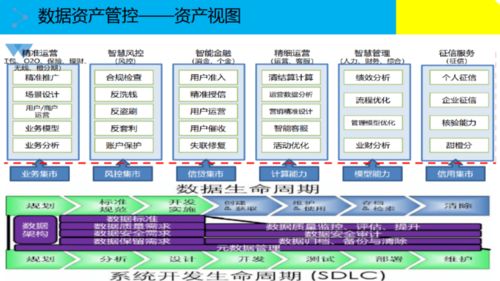

数据处理涵盖数据采集、清洗、转换、存储与分析等环节,是确保数据可用性与一致性的基础。在大数据治理框架中,高效的数据处理能帮助企业消除数据孤岛、提升数据可信度,并为AI、BI等应用提供可靠支撑。例如,通过标准化处理流程,企业可以减少数据冗余,避免因数据错误导致的决策偏差。

二、数据处理的核心策略与步骤

- 数据采集与集成:采用ETL(提取、转换、加载)或ELT工具,从多源系统中整合数据,确保数据完整性与实时性。例如,通过API接口或流处理技术(如Kafka)实现异构数据的统一接入。

- 数据清洗与标准化:识别并修复数据中的错误、重复或缺失值,应用规则引擎或机器学习模型自动校验数据格式(如日期、单位统一),提升数据质量。

- 数据转换与 enriched:通过聚合、关联或计算衍生字段,将原始数据转化为业务可用的信息。例如,利用SQL或Spark对用户行为数据进行分组统计,生成洞察报告。

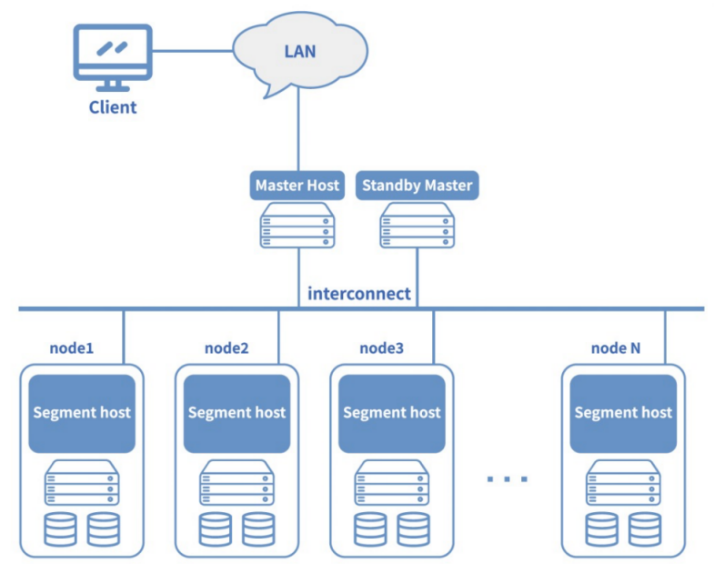

- 数据存储与管理:选择适合的存储方案(如数据湖、数据仓库),结合元数据管理工具,实现数据分类、权限控制与生命周期管理。

- 数据安全与合规:在数据处理过程中嵌入加密、脱敏机制,遵循GDPR、CCPA等法规,确保数据隐私与安全。

三、技术工具与平台支持

现代数据处理依赖于成熟的技术生态。例如:

- 批处理工具:Apache Spark、Hadoop用于海量数据离线分析。

- 流处理框架:Flink、Storm支持实时数据处理。

- 数据集成平台:Talend、Informatica提供可视化数据处理管道。

- 云原生服务:AWS Glue、Azure Data Factory简化了云端数据处理流程。

四、最佳实践与案例启示

成功的数据处理需结合组织需求与技术能力:

- 制定数据治理政策:明确数据所有权、处理标准与责任矩阵。

- 自动化与监控:通过工作流自动化减少人工干预,并设置数据质量指标实时告警。

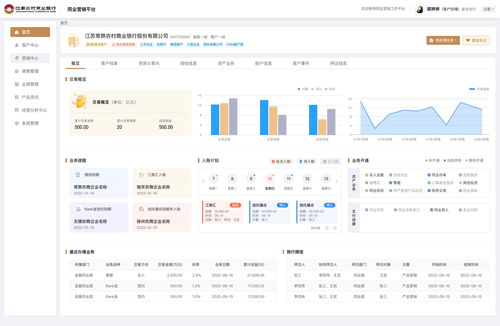

- 案例参考:某金融公司通过构建统一数据处理平台,将客户数据清洗时间缩短70%,显著提升了风险分析效率。

五、未来趋势与挑战

随着AI与边缘计算的发展,数据处理正朝向智能化、实时化演进。数据量的爆炸式增长与法规复杂性仍带来挑战。企业需持续优化处理架构,培养数据人才,以充分释放大数据价值。

数据处理是大数据治理的基石,通过系统化的策略与先进工具,企业能够将原始数据转化为可靠资产,驱动创新与增长。只有夯实这一环节,才能在数字竞争中立于不败之地。