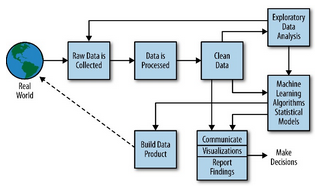

在数据驱动的时代,数据准备和数据处理是任何数据分析、机器学习或业务智能项目的基石。高效的数据管道不仅能够提升决策的准确性,还能显著节省时间和资源。以下是这两个关键环节的详细阐述。

一、数据准备:为分析奠定基础

数据准备是数据生命周期中的初始阶段,涉及采集、清理和整合原始数据,使其适合进一步处理。具体步骤包括:

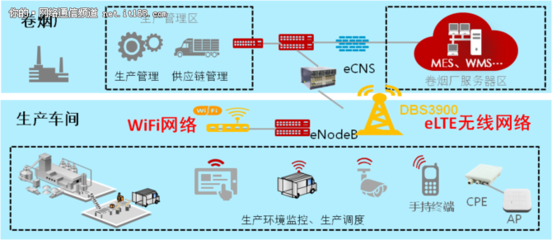

1. 数据采集:从多样化来源(如数据库、API、日志文件或传感器)收集数据。确保数据来源可靠,并考虑实时或批量采集方式。

2. 数据清理:识别并处理缺失值、异常值或重复记录。例如,使用均值填充缺失数值,或通过统计方法移除离群点,以提高数据质量。

3. 数据转换:将数据标准化为统一格式,如日期格式转换、单位统一或编码分类变量(如独热编码)。这一步有助于消除不一致性。

4. 数据集成:合并来自多个源的数据,解决数据冗余和冲突问题,例如通过主键关联不同表格。

数据准备的目标是产出“干净”的数据集,减少后续处理中的错误。据统计,数据科学家花费约80%的时间在数据准备上,凸显其重要性。

二、数据处理:从原始数据到可操作洞察

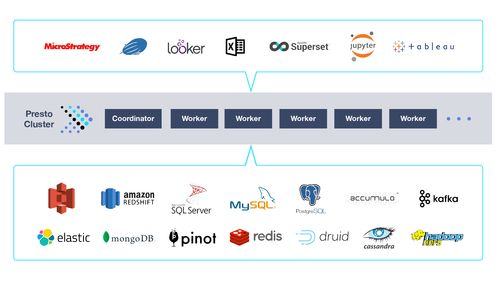

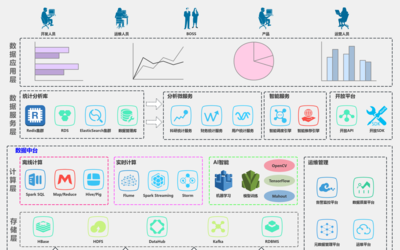

数据处理涉及对准备后的数据应用计算、聚合或建模技术,以提取有价值的信息。它可分为批处理和流处理两种模式:

1. 数据转换与聚合:使用工具如SQL或Pandas进行分组、排序和汇总操作。例如,计算销售数据的月度总和,或生成用户行为统计报告。

2. 特征工程:在机器学习中,创建新特征以增强模型性能,如从时间戳中提取小时信息,或生成交互特征。

3. 数据建模:应用算法(如回归、聚类或分类)进行预测或模式识别。这需要将数据分为训练集和测试集,以评估模型准确性。

4. 数据可视化与输出:通过图表或仪表板呈现结果,便于决策者理解。工具如Tableau或Matplotlib可辅助这一过程。

数据处理不仅提升数据的可用性,还支持实时应用,如欺诈检测或推荐系统。

三、最佳实践与工具

为确保数据准备和处理的效率,建议:

- 自动化流程:使用ETL(提取、转换、加载)工具,如Apache Airflow或Talend,减少人工干预。

- 确保数据安全:在处理过程中加密敏感信息,遵守GDPR等法规。

- 持续监控:定期检查数据质量指标,如完整性、一致性和时效性。

数据准备和数据处理是相辅相成的环节。前者为数据“净化”,后者赋予数据“生命”。通过系统化方法,组织能够将原始数据转化为可靠洞察,驱动业务增长。在人工智能和物联网兴起的背景下,掌握这些技能已成为数据专业人员的核心竞争力。